一种正规的性能调优方法:基于等待的调优

作者:网络转载 发布时间:[ 2013/4/24 15:29:28 ] 推荐标签:

访问日志是文本文件,可以手动检查(不是一个很有效率的任务),可以通过编程解析,也可以通过工具来分析。对此有很多商业解决方案,不过Quest Software有一个产品Funnel Web Analyzer,虽然多年以前已经终止开发,但是由于其很受欢迎的命令,公司作为将其作为自由软件重新发布。Funnel Web Analyzer可以分析大多数访问日志并显示用于创建合适负载测试的信息。

一些应用不像上面提到的那样简单,其用户交互无法很容易的通过一个URI来定位。例如,考虑一个包含前端控制器servlet的应用,该servlet接受一个XML有效信息——并且其业务处理逻辑存在于该信息中。在本例中,需要另外的工具来侦测其有效信息以判断其符合哪个业务场景。这可以通过使用 servlet过滤器或者一个称为终用户体验监视器的硬件设备来完成。

不管用户行为是如何获得的,它都是开始任何性能调优实践之前的关键先决条件。

全新应用

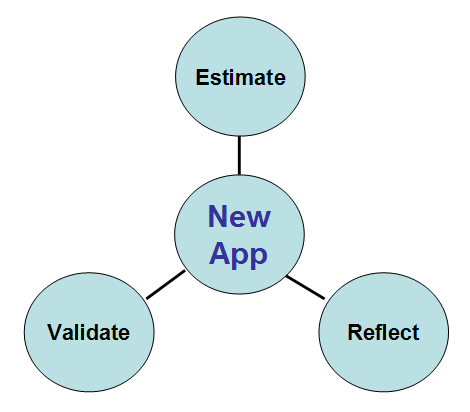

由于全新的应用没有任何终用户行为可以分析,所以对我们提出了一个独特的挑战。定位新应用的用户行为需要三个步骤,如图1所示。

图 1 评估新应用的终用户行为

第一步,评估终用户应该会做什么。这步是“猜一猜”的正式说法,但应该是一个经过培训的猜测过程。评估结果应该来自于以下双方的讨论:应用业务负责人和应用技术负责人。应用业务负责人,通常是一个产品经理,负责细化终用户应该如何使用该应用程序——例如,他可能报告说终用户会登陆、处理五个索赔请求、过期、处理五个索赔请求、生成两个报告、然后注销。应用技术负责人,一般是架构师或是技术lead,负责把业务交互的抽象列表翻译成用于生成负载测试的技术步骤——例如,他可能报告说登陆通过“/login.do” URI完成而处理一个索赔请求需要五个URI。这些人(或者小组或者一些大型项目里的委员会)应该一起提供足够的信息来建立一个基准负载测试。

我们建立负载测试,用其调整应用和容器,应用程序部署到生产环境中,这一切做完之后,调优工作并没有结束。下一步是验证负载测试集。这通常是一个多阶段的活动:

冒烟测试验证:在实际运行的一两周之内验证原先的评估值是否符合真正生产环境下终用户的行为。这步验证是为了确认在评估过程中没有明显的错误。

生产验证:一些应用需要用户花时间才能形成统一的使用方式。这个适应的时间长短因应用而异,可能是一个月或者一个季度,不过一旦用户的行为稳定下来,需要验证终用户行为是否与评估一致。

回归验证:好在应用的生产周期中阶段性的验证用户行为,以防止用户行为改变或者引入新的功能或工作流导致用户行为改变。

后一步,也是经常被忽视的一步,是反思。根据实际用户行为来反思评估的精确性是很重要的,因为只有通过反思,用户行为才能更便于理解,评估在以后的应用中才能得到提高。没有反思,相同的错误会一犯再犯,终会增加调优的工作量。

基于等待的调优方法

建好了负载测试,接下来是决定把调优精力放在何处。大多数调优指南都会提到“性能比率”或者度量之间的关系。例如,某调优指南可能强调说缓存命中率应该达到80%或者更高,因此负载测试应用时调整缓存大小直到命中率达到80%。然后处理列表上的下一个度量值,但是不要忘记验证调整新的参数不会影响之前已经调好的其他参数。

这项工作不仅困难而且效率很低。例如,调整缓存命中率到80%可能是件好事,但是存在一些更重要的问题:

该应用如何依赖于缓存(与该缓存交互的请求比例是多少)?

这些请求对应用中的其他请求有多大影响力?

被缓存的条目的本质是什么?它们真的需要缓存吗?

基于等待的调优方法提出了一个新的思想,即分析应用的业务交互和实现这些交互的底层结构,然后优化这些业务交互的处理。第一步是分析应用的架构以定位实现业务请求的相关技术。每一个技术代表一个“等待点”,或者说在应用的这个地方,请求可能需要等待一些事情才能继续处理。例如,如果一个请求执行了一次数据库查询,则它必须从连接池中获取一个数据库连接—如果连接池里没有可用的连接,则该请求必须等待直到有连接可用。同样,如果某请求调用了一个web服务,而那个web服务维护了一个请求队列(对应一个线程池处理请求),这会潜在的导致请求等待直到一个处理线程可用。

从以上称之为等待点分析的方法中,可以定位两种类型的等待点:

基于层次的等待点

基于技术的等待点

本节首先概述了基于等待点的架构分析方法,然后分别研究了不同类型的等待点。

等待点架构分析

从上面讨论中得出的重要的结论是性能调优必须在应用架构的环境中执行。这也是调优性能比率为何如此低效的一个原因:主观的调整一个性能参数到一个佳值,对应用可能是好事也可能是坏事——因为这可能会也可能不会有利于终用户体验。

sales@spasvo.com

sales@spasvo.com